Crawl Budget, nazywany również budżetem indeksowania witryny, określa liczbę stron, które robot Google jest w stanie zaindeksować w obrębie domeny.

W przypadku gdy dana witryna posiada wiele podstron jej indeksowanie może zajmować więcej czasu. Można więc przyjąć w uproszczeniu, że crawl budget to ilość podstron, jakie jest w stanie zaindeksować Googlebot podczas jednej wizyty.

Google wyszczególniło dwa główne parametry, które składają się na Crawl Budget:

- Crawl rate limit– limit współczynnika indeksacji

- Crawl demand– częstotliwość indeksacji

CRAWL RATE LIMIT

Roboty indeksujące Google starają się przejrzeć jak największą liczbę podstron w obrębie danej domeny. Z drugiej strony każda taka wizyta stanowi pewne obciążenie dla serwera. Dlatego też, aby nie zmniejszać wydajności witryny, co mogło by mieć negatywny wpływ na efektywność wyświetlania się strony dla potencjalnego użytkownika, zostały wprowadzone pewne ograniczenia. Crawl rate limit określa jak często konkretna domena jest indeksowana. Jest to stosunek liczby jednocześnie odwiedzanych podstron do czasu jaki upływa pomiędzy następującymi po sobie pobraniami przez Googlebota. Na częstotliwość pobierania wpływają następujące czynniki:

Crawl health – czyli “stan zdrowia crawla”. Jeżeli dana domena odpowiada bardzo szybko limit związany z ilością podstron jednorazowo pobieranych przez Googlebota zostaje zwiększony. Wpływ na ten parametr mają przede wszystkim aspekty techniczne takie jak prędkość ładowania się strony, czas odpowiedzi serwera itp.

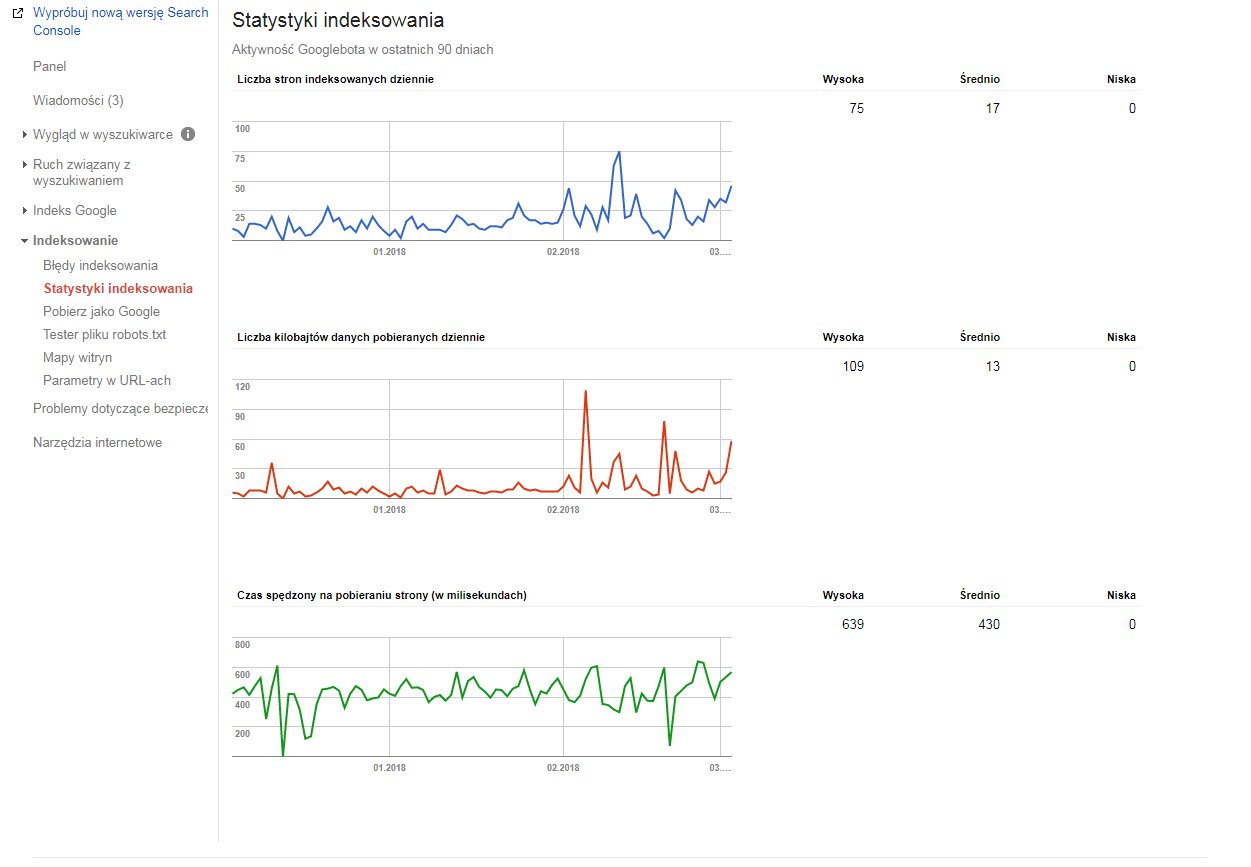

Dane dotyczące aktywności robota Google dostępne są w Search Console w sekcji statystyki indeksowania, która znajduje się w zakładce indeksowanie. Dzięki tym statystykom możemy określić, jaki jest nasz budżet indeksacji.

CRAWL DEMAND

Ten parametr można najprościej określić jako „popyt na indeksację”. Im strona ma większą wartość dla potencjalnego użytkownika tym chętniej będzie ona odwiedzana przez Googlebota. Nawet jeśli crawl rate limit nie został w pełni wykorzystany to strona może pomimo tego nie zostać zaindeksowana. Jeżeli nie istnieje „popyt na indeksację” to bot Google zmniejsza swoją aktywność na danej stronie. Na ten czynnik wpływ mają dwie cechy:

Popularność– adresy URL, które generują większą liczbę odwiedzin wśród użytkowników są również częściej odwiedzane przez roboty indeksujące.

Aktualność – algorytmy Google wykrywają czy i jak często dana podstrona jest aktualizowana, aby użytkownicy korzystający z wyszukiwarki mogli mieć dostęp do najświeższych informacji.

POZOSTAŁE CZYNNIKI, KTÓRE WPŁYWAJĄ NA BUDŻET INDEKSOWANIA

Nawigacja fasetowa – czyli popularne w sklepach internetowych filtrowanie produktów, technika ta sprawia, że dana podstrona może być dostępna pod nawet kilkunastoma adresami URL, co prowadzi do duplikacji treści

Duplikacja treści on-site – nie tylko w przypadku nawigacji fasetowej trzeba uważać na duplikację treści. Duplikacja treści w każdej postaci stanowi dla Google jeden z najważniejszych czynników wpływających na jakość strony. Każda treść powinna być jak najbardziej unikalna

Miękkie błędy 404 na podstronach – pojawiają się kiedy serwer zwraca kod odpowiedzi 200 na stronie, która nie istnieje zamiast kodu 404. Miękkie błędy zmniejszają zdecydowanie crawl budget. Na szczęście jeżeli pojawią się takie podstrony to w Google Search Console można je znaleźć w zakładce „błędy ideksowania”

Podstrony które zostały zhakowane – jeżeli istnieje prawdopodobieństwo, że strona padła ofiarą ataku hakerskiego może to znacząco obniżyć jej szanse na poprawne zaindeksowanie

Ogromne ilości podstron – najczęściej tworzone są poprzez parametry występujące w adresach URL. Może to być powodem masowej duplikacji treści

Treść o niskiej jakości lub spam – Google stara się być jak najbardziej bezwzględne w przypadku treści o niskiej jakości i w każdym przypadku, w którym istnieje prawdopodobieństwo spamu roboty indeksujące mogą uznać, że nie warto odwiedzać danej strony

Marnotrawienie budżetu indeksowania na strony zawierające błędy może doprowadzić do tego, że aktywność Googlebota zmaleje w tych miejscach gdzie indeksowanie jest najbardziej potrzebne. W efekcie nowe podstrony będą pojawiały się w wynikach wyszukiwania z dużym opóźnieniem.